Nota: El siguiente texto y el análisis realizado no pretenden ser exhaustivos. El texto no contiene referencias o citas. Al final he creado una sección bibliográfica.

Introducción

Muy posiblemente has llegado a este blog porque quieres saber lo que son las cámaras de eco o los filtros burbuja. Dos conceptos complejos, que tienen relación con el modo en cómo las redes sociales y plataformas ordenan los contenidos, y que causan efectos sobre nuestra forma de entender el mundo.

En los últimos años, las redes sociales han vivido un proceso en el que los criterios «tradicionales» de visibilidad de los contenidos han sido paulatinamente substituidos por mecanismos basados en decisiones algorítmicas. Es decir: vemos lo que la plataforma quiere, y para ello se tienen en cuenta una gran diversidad de factores.

El máximo exponente de esto es Facebook. Originalmente el muro de Facebook mostraba los contenidos de nuestros amigos siguiendo una lógica cronología: los contenidos nuevos desplazan a los antiguos, y así sucesivamente. Desde hace algún tiempo, Facebook tiene en cuenta otros muchos factores para decidir qué contenidos se van a mostrar primero. Uno de ellos, por ejemplo, es el grado de interacción. Si interactúas (das like, comentas, o sencillamente lees) con noticias relacionadas con el PSOE, cuando existan nuevos contenidos relacionados con el PSOE, estos se mostrarán primero, desplazando otros contenidos a posiciones de menor visibilidad.

Los efectos de estos mecanismos han sido ampliamente estudiados en el ámbito académico, y se traducen en dos teorías, que son vitales para comprender la influencia que ejercen las redes sociales sobre la opinión pública: las teoría de las «cámaras de eco» y la de «los filtros burbuja».

La teoría

Cámaras de eco: La teoría dice que este fenómeno se produce cuando las informaciones, ideas o creencias publicadas en redes sociales son amplificadas por la sucesiva transmisión y repetición, y las visiones divergentes, contrarias o competidoras son censuradas, prohibidas o simplemente no obtienen visibilidad.

En Facebook este fenómeno es algo inherente a la propia idiosincrasia de la red formada por los usuarios, me explico. En Facebook los usuarios suelen tender vínculos de amistad con otros usuarios, a los que conocen (familia, amigos, colegas de trabajo, etc), y con los que guardan afinidades (políticas, religiosas, familiares, etc). En pocas ocasiones se establecen vínculos entre usuarios que no se conocen, o con los que no existe afinidad ideológica alguna. Facebook acaba siendo un reflejo de nuestra red social “offline”, en la que, por supuesto, también establecemos lazos con personas afines.

Entonces, es difícil que en nuestro muro de Facebook aparezcan ideas contrarias a nuestra ideología. La red social es, de algún modo, una habitación donde la información rebota y se amplifica. En muy pocas ocasiones veremos en nuestro muro de Facebook contenidos que chocan de frente con nuestra percepción. La ausencia de posiciones encontradas favorece, además, que esta información a menudo se distorsione, debido a la inexistencia de actores contrarios que aporten visiones alternativas, y la imposibilidad de contrastar fuentes.

Filtros burbuja: Este fenómeno es fruto de los procesos realizados por los algoritmos que las redes sociales aplican para determinar la visibilidad de los contenidos y el orden en el que aparecerán en nuestro muro.

Se produce cuando la plataforma determina el contenido que el usuario va a visualizar, a partir de predicciones basadas en la información del usuario (su localización, su historial de búsquedas, interacciones pasadas, etc). Debido a este “filtro previo”, la plataforma oculta deliberadamente ciertos contenidos al usuario. El usuario no puede acceder a puntos de vista conflictivos y queda encerrado en un posible sesgo informativo.

El peligro los filtros burbuja reside en el aislacionismo intelectual al que se somete inconscientemente al usuario, llegando a pensar (incluso) que el mundo se ajusta a lo que muestra el muro de Facebook. Los riesgos de este sesgo se han hecho mucho más evidentes ahora, con la llegada de las “fake news”, que han puesto sobre la mesa la credibilidad y vulnerabilidad de los usuarios cuando se exponen a desinformación en un sistema cerrado al que no pueden acceder nuevas ideas o emisores.

El caso de estudio

Siguiendo con el ejemplo de la anterior publicación (Entrada anterior), me he propuesto averiguar hasta que punto Youtube favorece que un usuario sea sometido a una cámara de eco o filtro burbuja. Y esto es relevante por dos motivos. Primero, Youtube no es una red social o, al menos, no lo es del mismo modo que lo es Twitter o Facebook, las personas no acuden a Youtube a consumir contenidos del mismo modo que lo hacen en Facebook, tampoco establecen vínculos de amistad. El segundo, es la evidente proliferación de contenidos de desinformación en la plataforma.

En el año 2017 y 2018 Youtube puso en marcha algunas iniciativas que buscan acabar con la diseminación de desinformación en su plataforma. Una de ellas, por ejemplo, es la creación de una acreditación de “fiabilidad”, a la que podrán acceder los medios de comunicación, y con la que se obtendrá una mayor visibilidad dentro de la plataforma. Así, cada vez que alguien publique (por ejemplo) un vídeo sobre un atentado terrorista, Youtube intentará mostrar o recomendar al usuario la visualización de un vídeo informativo creado por un medio de comunicación, al que se le presupone mayor calidad informativa. Otro ejemplo de esta lucha, serán los enlaces a la Wikipedia o la Enciclopedia Británica, incrustados en vídeos considerados polémicos, a fin de favorecer la entrada de información de fuentes fidedignas y ofrecer al usuario la posibilidad de contrastar los datos (El Confidencial).

Puede parecer una tontería, cierto. ¿Qué capacidad de influencia tiene youtube sobre las personas? Es difícil de medir. Pero si bien es cierto que algunas desinformaciones son inocuas, atajar y tratar esta cuestión es de vital importancia cuando la desinformación se adentra en temas cruciales para la vida de las personas, o el correcto desarrollo social, como por ejemplo el cambio climático o el movimiento anti-vacunas.

Para este caso, he elegido los 20 vídeos más vistos sobre terraplanismo de Youtube en habla hispana (que incluye el vídeo de VSauce, que está en inglés), y he realizado una extracción de la sección de “vídeos relacionados” (mediante API) para cada uno de ellos.

Objetivo

Ver qué contenidos recomienda o relaciona Youtube partiendo de 20 vídeos sobre la teoría de la tierra plana.

Hipótesis

Escribo este apartado a modo de predicción, sin haber analizado los resultados, para luego observar si mis hipótesis son ciertas. Esto es algo que no se debería hacer desde un punto de vista científico, porque parto de algunos prejuicios. Las hipótesis son las siguientes:

- Youtube NO aporta contenidos relacionados que permitan contrastar o contrarestar los argumentos terraplanistas.

- Youtube me ofrecerá contenidos relacionados que no tienen nada que ver con el tema que estoy tratando. Me los mostrará porque son tendencia, o porque se trata de contenidos de consumo elevado, y monetizado, reportando beneficios a creador y plataforma.

En este punto es importante recordar que los datos han sido extraídos usando la API de Youtube. Esto elimina el sesgo de usuario, por lo que Youtube no me retornará contenidos basados en mis gustos.

Resultados

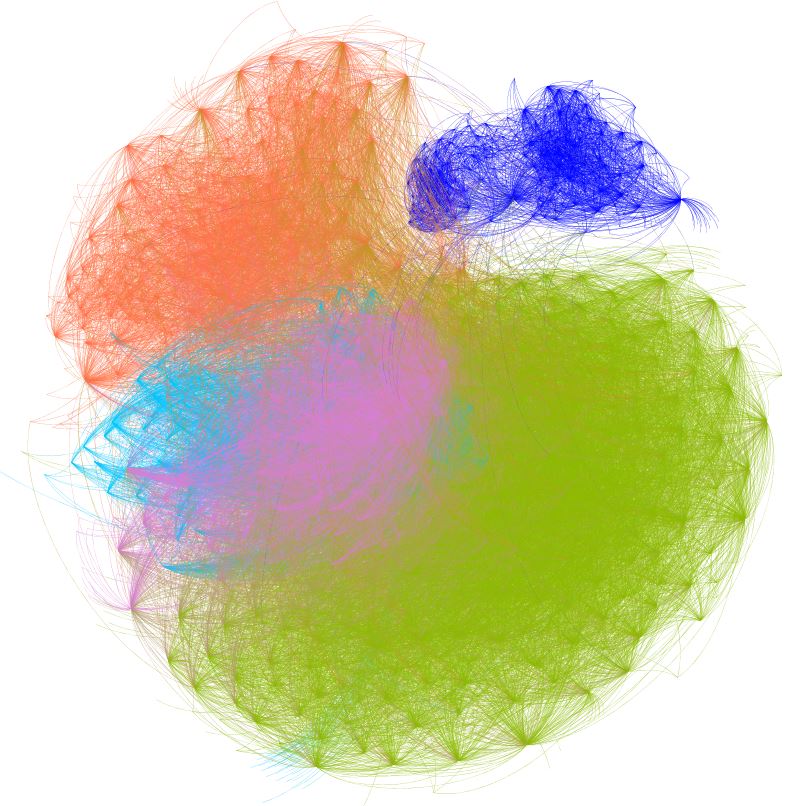

Para conocer el tipo de contenidos que Youtube recomienda y relaciona con los 20 vídeos “de partida”, vamos a recurrir a una visualización de grafo. La siguiente visualización está compuesta por más de 1500 vídeos relacionados. Cuando un vídeo aparece en la sección de relacionados de otro vídeo, se establece un vínculo (arista). Cuando aparece en otro vídeo, se añade una nueva arista. De este modo, los vídeos van sumando vinculaciones dependiendo de la cantidad de veces que aparecen (o no) en la sección de vídeos relacionados.

Cuando un vídeo aparece relacionado con otro vídeo, además de generar una arista, se genera un punto de atracción. Así, cuando varios vídeos se relacionan entre ellos, generan “nubes” de comunidad, en las que la relación es muy próxima entre ellos. El grafo resultante es el siguiente.

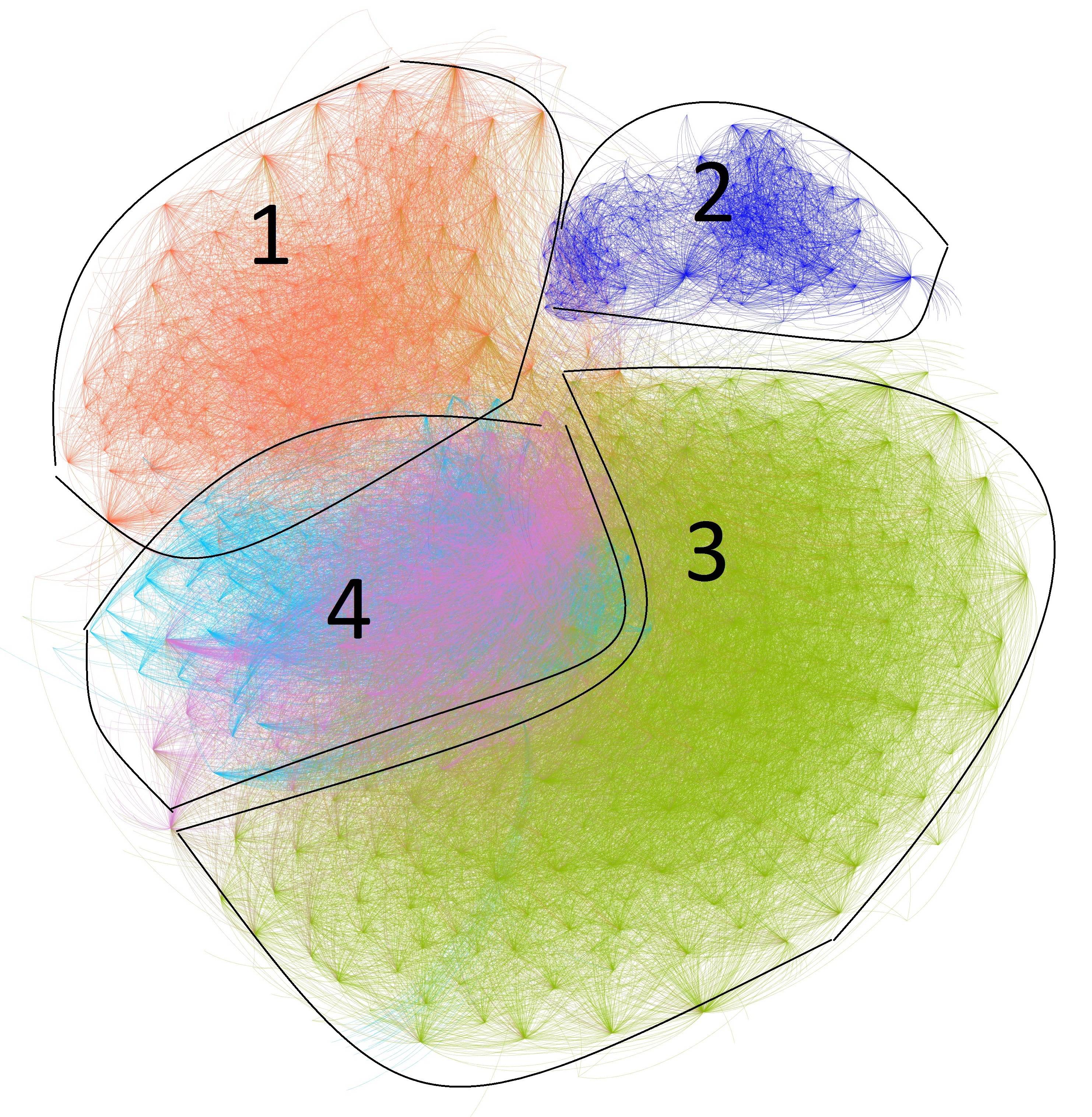

El grafo resultante es una inmensa nube de contenidos relacionados. Cada nodo representa un vídeo, y cada arista es una vinculación entre vídeos, a partir de su aparición en la sección de «relacionados». Debido a las limitaciones técnicas de el formato blog, me resulta totalmente imposible ofrecer el grafo con el máximo detalle. He omitido los nombres de cada nodo. Pero en una vista global del grafo, se pueden identificar rápidamente 4 comunidades de vídeos relacionados, distinguidos por cuatro colores diferenciados. Como he comentado, cada comunidad está formada por vídeos que guardan mucha relación entre ellos.

Si se analiza en detalle, aproximando cada parte del grafo, he podido obsercar que cada una de estas comunidades corresponde a un tipo de vídeos concreto:

- Comunidad 1: Documentales sobre ocultismo, misterios sobre la tierra, ciencia espacial y otros contenidos de pseudociencia de baja calidad.

- Comunidad 2: Vídeos sobre terraplanismo en inglés, que posiblemente proceden de la sección de vídeos relacionados con VSouce. Todos ellos, son vídeos pro-terraplanismo, a pesar de que el vídeo en el que aparcen relacionados aporta una visión anti-terraplanismo.

- Comunidad 3: Vídeos que abordan el terraplanismo desde perspectivas bíblicas y otros vídeos sobre conspiraciones y manipulaciones del gobierno.

- Comunidad 4: Contenidos de consumo masivo que no tienen relación con el tema tratado, pero que Youtube recomienda por probabilidad de consumo. Encontramos vídeos musicales de grandes artistas del momento y otros contenidos de índole viral.

Ejemplos

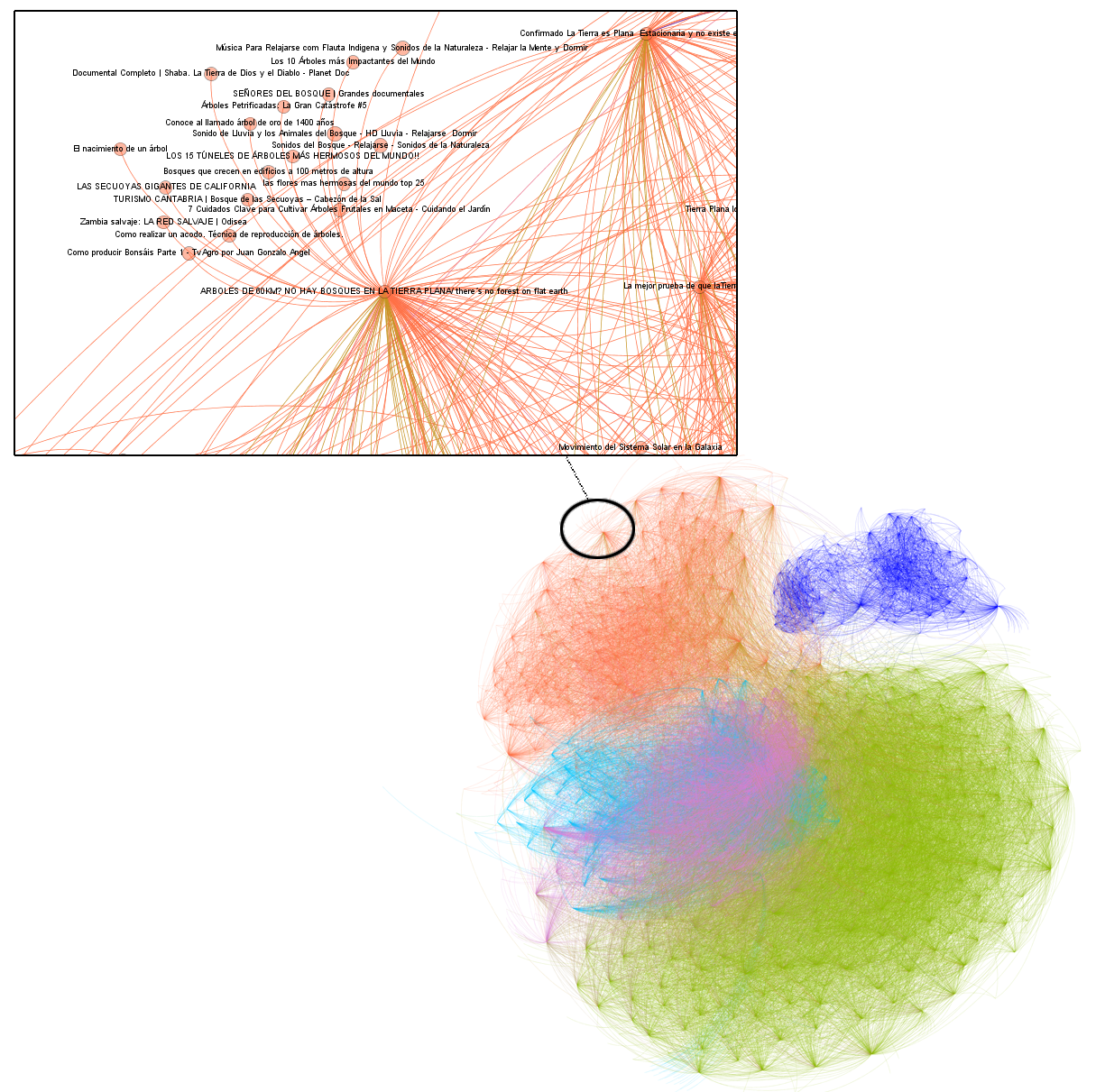

Los vídeos se agrupan en comunidades. Estas comunidades se forman a partir de las veces que un vídeo aparece recomendado en la sección de «relacionados». En la siguiente imagen, he seleccionado un pequeño segmento de la comunidad 1, donde podemos observar las temáticas de vídeos relacionadas. En este caso, el hilo conductor de los vídeos es la temática «árboles». (Podéis ampliar la imagen haciendo clic)

Conclusiones

Las hipótesis de partida eran correctas. Tras analizar el grafo se puede observar que la cantidad de contenidos de índole científica es muy bajo, por no decir inexistente. Partiendo de 20 vídeos iniciales que hablan sobre terraplanismo, el resultado son contenidos relacionados que contienen otro tipo de desinformaciones o teorías conspiratorias. Es decir: si consumes vídeos terraplanistas, YouTube te empuja o recomienda ver otros contenidos que siguen la misma lógica.

Es relativamente fácil, para alguien que tiene interés en el tema, navegar a través de la sección de «contenidos relacionados» y no encontrar absolutamente ningún vídeo discordante con la teoría del terraplanismo, algo que se asemeja bastante a lo que es una cámara de eco. Si a esto le sumamos, que Youtube aplicará la lógica del algoritmo para recomendar vídeos al usuario, de forma personalizada, y en sucesivas visitas a la plataforma, es muy probable que se impacte continuamente al usuario con vídeos de pseudociencia, lo que acabará por reforzar el mensaje y producirá un efecto de filtro burbuja.

Bajo mi punto de vista, no hay fundamento alguno para que una persona adulta y formada, con espíritu crítico, crea en el la teoría de la tierra plana, pero debemos reflexionar sobre el impacto que puede tener este sistema sobre un niño que todavía no ha desarrollado las habilidades necesarias para detectar y contrastar la desinformación.

Bibliografia

- Del Vicario, M., Vivaldo, G., Bessi, A., Zollo, F., Scala, A., Caldarelli, G., & Quattrociocchi, W. (2016). Echo chambers: Emotional contagion and group polarization on facebook. Scientific reports, 6, 37825.

- Quattrociocchi, W., Scala, A., & Sunstein, C. R. (2016). Echo chambers on Facebook.

- Garimella, K., Morales, G. D. F., Gionis, A., & Mathioudakis, M. (2018). Political discourse on social media: Echo chambers, gatekeepers, and the Price of bipartisanship. arXiv preprint arXiv:1801.01665.

- Bakshy, E., Messing, S., & Adamic, L. A. (2015). Exposure to ideologically diverse news and opinion on Facebook. Science, 348(6239), 1130-1132.

- Flaxman, S., Goel, S., & Rao, J. M. (2016). Filter bubbles, echo chambers, and online news consumption. Public opinion quarterly, 80(S1), 298-320.

- Pariser, E. (2011). The filter bubble: What the Internet is hiding from you. Penguin UK.

- Zuiderveen Borgesius, F., Trilling, D., Moeller, J., Bodó, B., de Vreese, C. H., & Helberger, N. (2016). Should we worry about filter bubbles?.

- Rieder, B., Matamoros-Fernández, A., & Coromina, Ò. (2018). From ranking algorithms to ‘ranking cultures’ Investigating the modulation of visibility in YouTube search results. Convergence, 24(1), 50-68.

- Matamoros-Fernandez, A., Rieder, B., & Coromina, O. (2016). Visibility matters: An exploration of YouTube ranking culture.